本文目录一览:

100:0,新AlphaGo放弃了人类?

1、AlphaGo Lee完败于摒弃了人类经验的AlphaGo Zero,这说明人类的经验可能误导了AlphaGo Lee,进而限制了它的发展。

2、年10月19日凌晨,在国际学术期刊《自然》(Nature)上发表的一篇研究论文中,谷歌下属公司Deepmind报告新版程序AlphaGo Zero:从空白状态学起,在无任何人类输入的条件下,它能够迅速自学围棋,并以100:0的战绩击败“前辈”。

3、现在有可能技术还有差距,但是个趋势。马云说是一样,“我不一定能成功,但有人能成功”人类发展要经过的阶段。

比较分析alphago新算法和蒙特卡罗不同之处?

性能、领域不同。人工智能的性能为AI智能,蒙特卡洛技术不是AI技术。人工智能的领域十分广泛,运用于生活中,蒙特卡洛算法仅仅需要经验就可以进行学习,通过平均样本的回报来解决强化学习问题。

他们有类似之处,但差别也不小。蒙特卡洛算法是数值计算方法,原理是利用随机数来解决计算问题。与它对应的是确定性算法。也就是说该种算法属于随机算法,得到的解是近似解。

一对分别名为马尔科夫和蒙特卡洛的名侦探组合就此登场,他们说:“首先,我们先随便猜一个平均值μ,比如μ(1) = 0.8好了。

【转载】AlphaGo原理解析

“阿尔法狗”利用超过170个GPU,粗略估算超过800万核并行计算,不仅有前期训练过程中模仿人类,自我对弈不断进化,还有实战时的模拟对局可以实时进化,已经把现有方法发挥到了极限,是目前人工智能领域绝对的巅峰之作。

AlphaGo的原理 首先,AlphaGo同优秀的选手进行了150000场比赛,通过人工神经网络找到这些比赛的模式。然后通过总结,它会预测选手在任何位置高概率进行的一切可能。

据阿尔法围棋团队负责人大卫·席尔瓦(Dave Sliver)介绍,AlphaGoZero使用新的强化学习方法,让自己变成了老师。系统一开始甚至并不知道什么是围棋,只是从单一神经网络开始,通过神经网络强大的搜索算法,进行了自我对弈。

阿尔法围棋(AlphaGo)是一款围棋人工智能程序。其主要工作原理是“深度学习”。“深度学习”是指多层的人工神经网络和训练它的方法。

AlphaGo Zero的能力则在这个基础上有了质的提升。最大的区别是,它不再需要人类数据。也就是说,它一开始就没有接触过人类棋谱。研发团队只是让它自由随意地在棋盘上下棋,然后进行自我博弈。

AlphaGo算是人工智能,其具体工作原理说白了就是一个穷举的过程,一个不断迭代的过程。人一生之中也就能下几千盘高质量的棋局,但是AlphaGo一天能下几万甚至几十万盘棋局。而且AlphaGo就像圣斗士,同样的错误不会犯第二次。

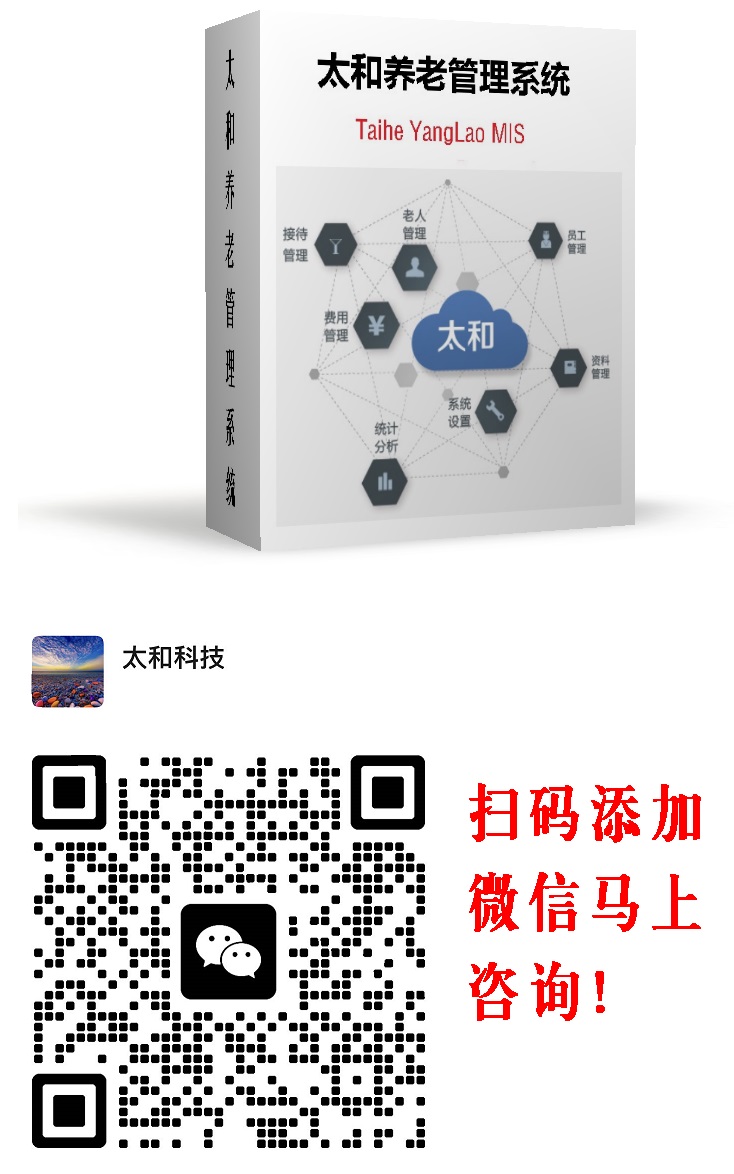

扫码加微信详细咨询太和智慧养老产品和平台服务!